随着自然语言处理技术的发展以及客户需求的提高,当机器人进入以人为主的环境时,必须学会理解人类语言,完成指定任务。相较于传统只对场景做出反应的机器人操作方法,结合语义输入,让机器人理解人类语言,根据场景和自然语言指令完成相应任务,能为人机协作带来更大的便利性。然而,目前该方法具有如下限制:

(1)依赖手工编码任务符号来实现语义表达,限制了语义层面的泛化性。

(2)从指令中推断动作序列时,需要密集的子目标监督。

(3)缺乏更深层次的以目标为中心的推理方法,在解释复杂指令时不连贯。

针对上述问题,该文章提出了一种可感知视觉场景,同时处理语言输入的端到端可训练的模型。该模型使用视觉输入得到当前场景中物体在初始状态下的位置关系,以语义文字推理目标状态下对应的位置关系,实现由自然语言引导机器人进行技能操作。

相关成果以“Learning Neuro-symbolic Programs for Language Guided Robot Manipulation”为题发表于International Conference on Robotic and Automation (ICRA)会议中。

该文章提出了一种新型神经符号模型,使用自然语言推理目标场景,实现在给定初始场景和目标场景的情况下即可学习执行复杂的操作任务,并展示了如何在不需要任何中间监督的情况下,仅使用初始与目标两个场景作为监督来获取机器人操作动作的密集表示。

实验表明,该文章的方法可通过端到端的训练而不需进行任何子目标监督,即可展现出强大的指令理解能力,并对新场景和指令展现出强大的泛化能力,为将来基于自然语言的人机协作,机器人的语义指令集的拓展提供了新的参考思路。

1、模型结构设计

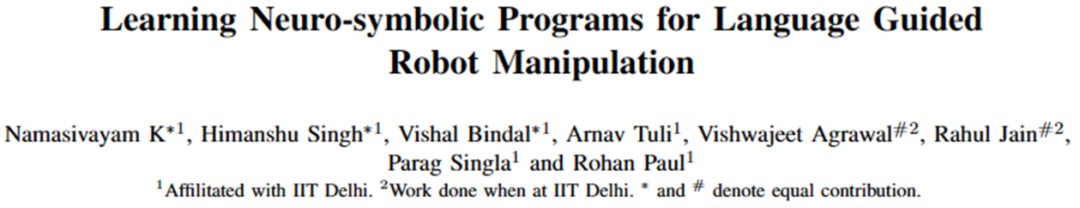

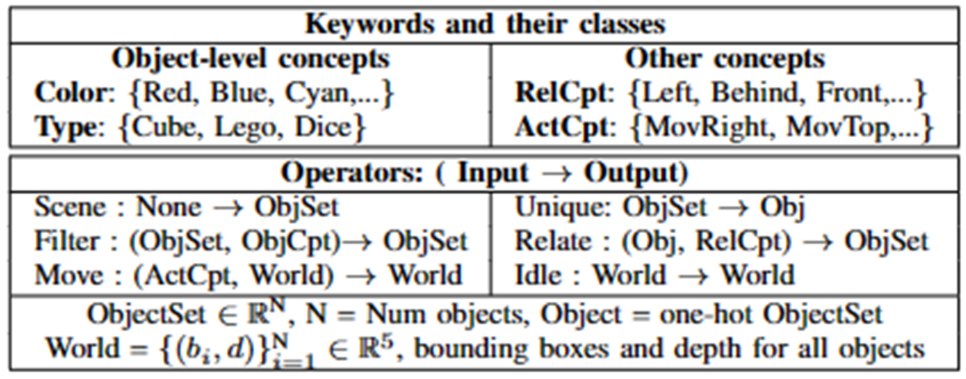

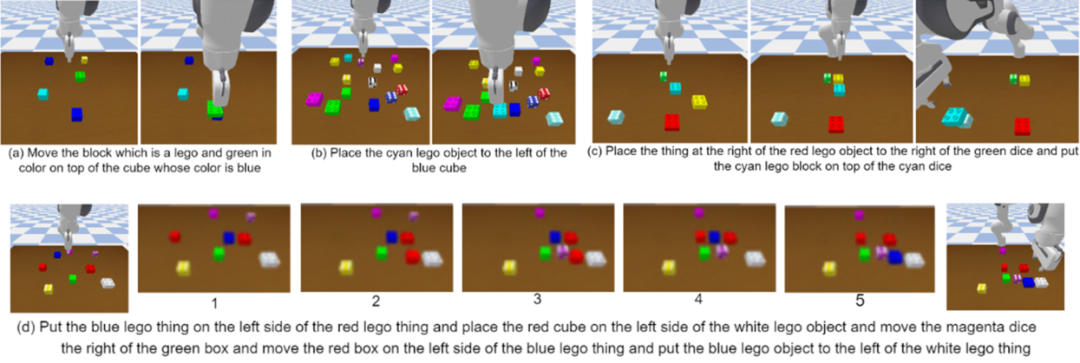

该端到端模型的结构如图1所示,由视觉提取器、语言解释器、视觉解释器、动作模拟器组成。输入初始场景和基于自然语言的任务指令,模型输出完成该指令所需的动作参数,以及预测完成任务后的最终场景。

视觉提取器相当于一个目标检测模型,用于识别初始场景下的物体信息。以图11为例,输入桌面初始状态的图像,视觉提取器输出各个物体的外接框、颜色信息及物体名称,并由外接框在桌面上的相对位置推断物体的位置信息。

语言解释器用于处理自然语言指令推理任务中隐含的操作动作。例如图中“移动绿色骰子后面的红色骰子至红色方块的右边”这句指令,语言解释器经过推理会得到完成该任务需要进行“移动”动作,移动的物体是“位于绿色骰子后面的红色骰子”,目标是“红色方块右边”,并可屏蔽“绿色方块”和“蓝色骰子”这些与完成任务无关的信息。推理完毕后,以专用指令集组合出推理结果。

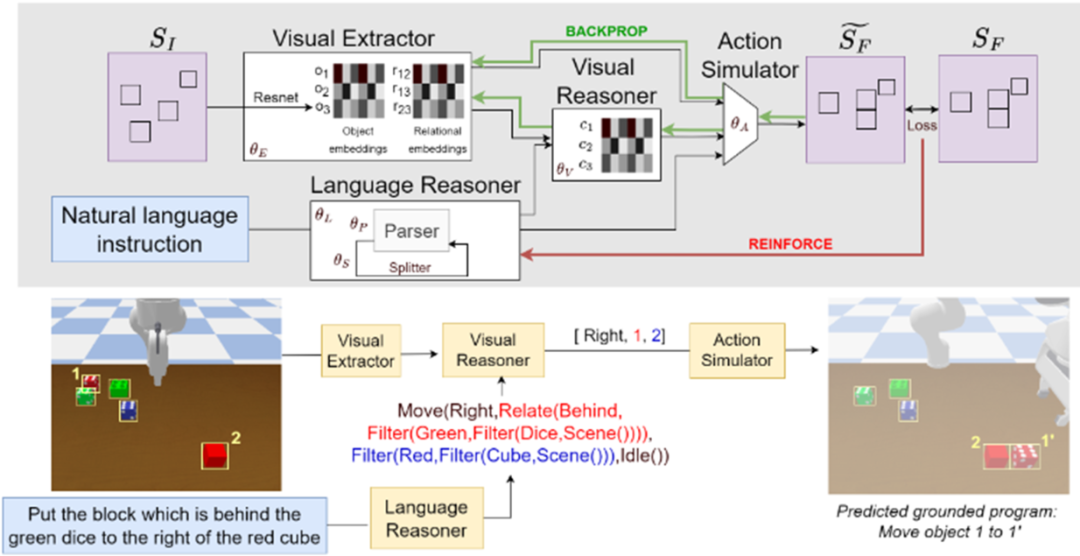

专用指令集的结构如图2所示,分为“关键词”和“操作词”,前者用于描述物体信息,后者用于表示操作信息。

视觉解释器结合前二者输出的场景信息和任务指令集,输出完成该任务所需的参数化表示,交由任务模拟器生成机器人所能执行的动作参数,并预测完成任务后的场景情况。

以预测场景和数据集中提前设定好的目标场景做差,设置损失函数,即可实现端到端的训练过程。

图1 模型结构

图2 专用指令语言

2、实验设置

1)数据收集

文章使用Franka Emika Panda机械臂,在Pybullet虚拟环境中收集数据,每组数据由初始场景图像、语言指令和目标场景图像组成。在虚拟环境中,每次使用3-5个随机颜色的方块随机放在桌面上,给定语言指令,并设置目标状态,收集两个状态下的图像数据,一共得到5000个场景的图像与语言数据,以8:2的比例划分为训练集和测试集。

其中,语言指令分为“单步指令”(如“移动红色方块”)和多步指令(如“移动红色方块至绿色方块右边”),以便模型能对简单指令和复杂指令做出良好的推理结果,深入地推理语义文字中隐含的任务信息。

2)对比实验

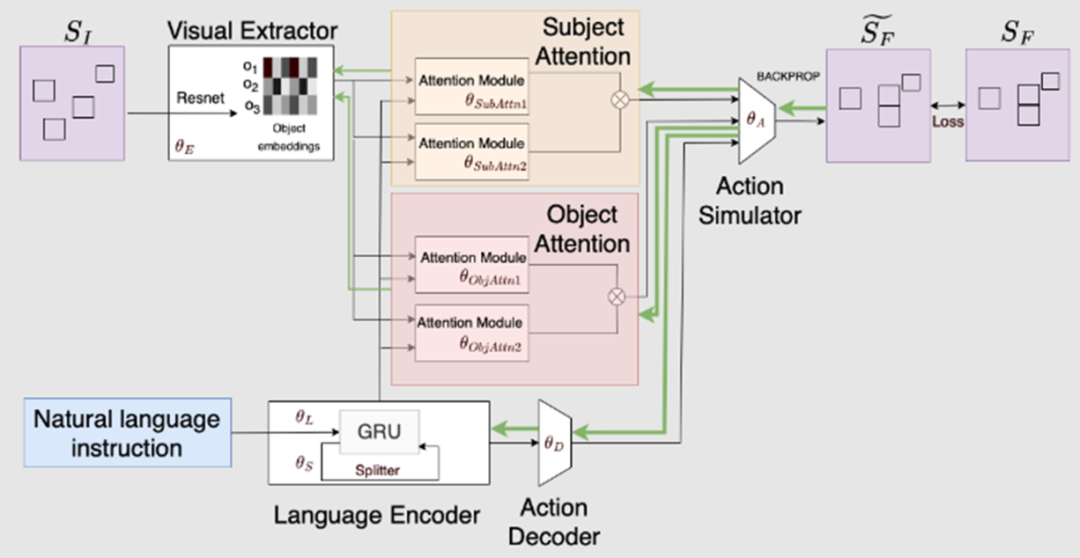

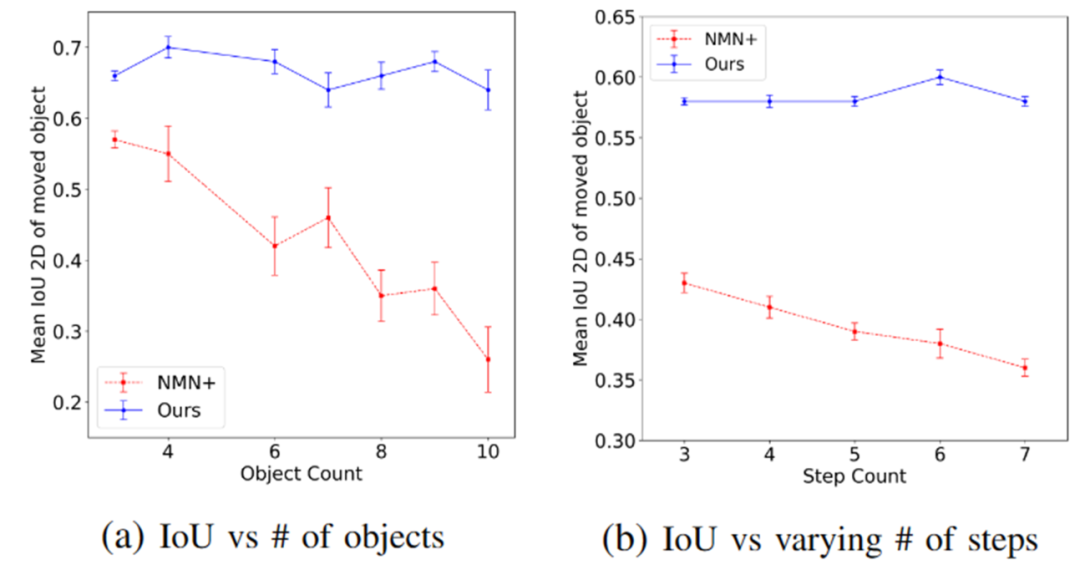

如图13所示,文章使用注意力机制替代视觉解释模块,并引入编码器和解码器替代语言解释器,进行端到端的训练,使用MIoU指标评价两种模型的视觉提取器得到的物体外接框质量,以此判断不同模型的识别精度。结果表明文章的方法在理解场景,识别物体的效果上更好。

图3 对比模型

图4 两种模型的MIou对比

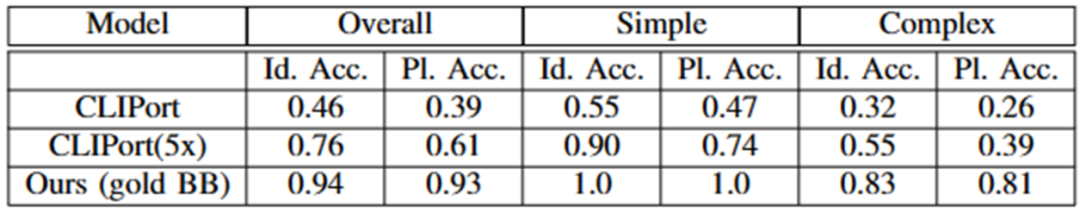

为证明文章提出的语义引导操作方法具备更强的推理能力和任务执行能力,作者对比了文章所用方法和谷歌公司最新提出的同样以视觉和语义为输入的CLIPort方法在抓取任务上的成功率,结果表明该文章所用方法效果更好。

图5 与CLIPort在抓取成功率上的对比

最后,为了实验文章所用方法的鲁棒性,作者通过增加桌面上的物体数量和增加输入自然语言指令的长度,查看机器人在抓取任务上的完成情况,结果表面,对人类提出的指令,机器人均能较好地完成。

图6 改变物体数量和增大语义指令长度

3、总结与展望

该文章提出了一种神经符号架构,通过视觉语言推理,理解场景和指令,以完成预期目标。与之前的工作不同的是,该方法不需承担任何子目标监督,可端到端地训练模型,并与其他方法相比,该方法对新场景和新指令体现出强大的泛化能力。未来可在此基础上扩展更丰富的指令空间,或使用更好的语义理解模块和视觉识别模块,以便更好地依据人类语言进行人机协作。

该文章得到了DARPA可解释人工智能(XAI)计划、IBM人工智能地平线网络(AIHN)以及印度理工学院德利分校CSE研究加速基金的支持。